Le necessità reali, le vite e le morti reali, che non sopportano di essere ridotte a interpretazioni, sono tornate a far valere i loro diritti. Maurizio Ferraris, Manifesto del Nuovo Realismo

.Ha appassionato tutti gli studiosi e gli spettatori questo versante “iperreality” del teatro: stiamo parlando della nuova (ma non nuovissima) tendenza del teatro; come ben spiegato nel dossier di “Hystrio” (2/2019) sul Teatro della realtà curato da Roberto Rizzente e Corrado Rovida, specialmente nell’intervento di sintesi storica scritto da Renato Palazzi, questo filone di teatro-documento che ha il suo emblema in Milo Rau, recupererebbe forme e approcci teatrali degli anni Sessanta (dagli happeining a Peter Weiss a Carlo Cecchi). Si espande dalle biografie, all’analisi di fatti cronachistici agli spaccati socio-politici (She she pop), alle storie di emarginazione sociale (Pippo Del Bono) per giungere a veri e propri brandelli di realtà in scena. I famosi “quarti di bue sul palco” nel teatro-tranche de vie di Antoine citati da Palazzi sono tornati di moda?

Di fronte alla realtà -diremo filosoficamente- “evenemenziale”, “fattuale”, non c’è interpretazione che tenga. Serve un occhio critico che smascheri e ci faccia riconoscere ciò che è da ciò che è socialmente costruito. Un ritorno a una realtà –come dice il filosofo Maurizio Ferraris nel Manifesto del Nuovo Realismo– “non emendabile”, contro falsificazioni, mistificazioni mediatiche e omologazioni. Congedo dal realitysmo (la vita drammatizzata e fictionizzata) e approdo al Nuovo Realismo? -seguendo ancora Ferraris.

E cosa accade al teatro tecnologico?

A mio avviso il teatro tecnologizzato arriva a una medesima conclusione e a un medesimo approdo interrogandosi sulla realtà in un momento molto preciso: con l’Orfeo, opera lirica a firma di Romeo Castellucci. Non si tratta di usare semplicemente una semplice diretta video come già avevano fatto evidentemente in molti: è il concetto di “presenza” a pesare sulla bilancia del palcoscenico e a mostrare l’altro lato del teatro, ovvero la Realtà cos’ com’è, inesorabile e inequivocabile. Il mito greco si incarna nella figura di Else, una donna in coma vigile, ferma sulla soglia tra vita e morte e a cui il teatro concede un momento di sospensione dell’attesa, con l’ascolto celestiale della musica di Gluck/Berlioz. La donna che non si sarebbe congedata da noi, a meno che non fossimo noi stessi a staccare la spina del collegamento video, diventava -potenza del teatro- Euridice sulla soglia degli inferi, oppure Ofelia nella dimora del tempo sospeso dentro la macchina amletica di Heiner Muller. Else ci sbatte in faccia la realtà in un tempo-ora, ed è ancora Ferraris a darci la chiave per leggere la storia:

Non si può fare a meno del reale, del suo starci di fronte e non essere disponibile a negoziare. Sia quello che sia, ci renda felici o infelici, è qualcosa che resiste e che insiste, ora e sempre, come un fatto che non sopporta di essere ridotto a interpretazione, come un reale che non ha voglia di svaporare in reality.

1.Verso una Realtà proxy: la visione di Hyto Steyerl dell’Arte al tempo del “panico del dasein totale“

Duty free art è il titolo del libro dell’artista e filosofa tedesca di origine giapponese Hyto Steyerl, nominata come la più influente artista contemporanea dalla rivista “Art review”; la Steyerl (che in questo periodo espone a Rivoli, alla Biennale di Venezia e alla Serpentine gallery di Londra) lavora sul tema della Intelligenza Artificiale (A.I.): crea opere di arte visiva con uso di AI e riflette attraverso l’arte, sulle trasformazioni e deformazioni della società e dell’arte stessa all’epoca di quello che lei definisce con un neologismo molto efficace il circolazionismo delle immagini. La Steyerl non fa teatro ma i suoi testi possono avere un riflesso anche nel teatro perché parla di presenza, tema evidentemente molto teatrale: mai come oggi, dice, il vero valore dell’arte dipende dalla presenza, citando la performance della Abramovic, The artist is present. Infatti oltre a produrre opere l’artista deve produrre presenza, deve essere presente in una delle molte declinazioni del tema, in un lavoro che diventa a sua volta una vera performance dell’esserci. Essere qua effettivamente ora. Qua o ovunque, noi o qualunque altra incarnazione del noi: una presenza sempre connessa, che moltiplica i nostri stati in una dimensione multipla in forma di proxy, controfigure, bot. Il corpo non è essenziale, è essenziale la presenza, la presenza è, secondo le parole della Steyerl una ” modalità di investimento”. Questa sorta di economia globale della presenza genererebbe di conseguenza il panico da dasein totale.

Ma che realtà producono queste appendici di noi stessi, queste informazioni automatiche gestite da nostri sostituti in forma di assistenti-software, che mandano tweet al posto nostro, che chattano usando il nostro gergo? Producono, appunto, dice la Steyerl una realtà proxy. In sostanza, per dirla con Johnny Stecchino, una realtà che “non ci somiglia per niente”.

2.Dall’illusione della realtà alla Realtà vista dalle macchine: il videomapping.

Verificando quale sia stata la tecnologia più usata negli ultimissimi anni, cioè il videomapping (tecnologia di Realtà aumentata) ci si può rendere conto che si è andati sempre più verso una richiesta di interazione, azione, presenza di una live technology.

Dalla scena urbana su enormi superfici addirittura media facade si è approdati a teatro: sempre di più le scenografie diventano ricoperte di questa illusoria e neobarocca “luce videomapping”. L’illusione della realtà ha però, un limite legato alla percezione.

La tecnica infatti, è quella del mapping and masking, che sfrutta la pre-distorsione dell’immagine o del filmato per farlo apparire non distorto sulla superficie da mappare. La proiezione deve essere prima di tutto perfettamente omografa: due piani risultano essere omografici quando gli elementi geometrici dell’uno corrispondono biunivocamente a quelli dell’altro. Qualunque alterazione della distanza e dell’angolo di incidenza del fascio luminoso implica modificazioni dimensionali e prospettiche dell’immagine, e conseguentemente irregolarità geometriche e defocalizzazioni più o meno estese dell’immagine proiettata. E’ necessario considerare inoltre, la posizione degli spettatori (max + o -15°) rispetto alla proiezione per ridurre gli effetti di percezione innaturale del 3D.

Siamo di fronte a una rinnovata “macchina di visione”: in fondo le video proiezioni in mapping si basano sullo stesso principio su cui erano fondate anche le “visioni ineffabili” del Cinquecento, quelle cioè, soggette all’anamorfosi, legate alla forzatura estrema della prospettiva lineare rinascimentale. Nelle opere anamorfiche, la realtà può essere percepita solo attraverso uno specchio deformante, mentre il mapping video non è che una maschera che deforma/crea una realtà inesistente. Sul tema ho ampiamente scritto su varie antologie; qua segnalo il mio testo: Mediaturgia del videomapping.

3.Dall’illusione all’interazione: il videomapping e il motion tracking design

Il limite del videomapping, tecnica di proiezione di realtà aumentata applicata in scenografia che ormai sta cadendo in disuso, non era legato solo alla fragilità della percezione e dell’illusione, ma all’esigenza di avvicinarsi di più alla realtà: alla ricerca di ciò che determina l’esserci della tecnologia a teatro, gli artisti hanno incontrato l’attore, il performer, il danzatore.

Il limite del videomapping statico e “poco teatrale” viene ovviato con l’aggiunta di software che permettono la gestione live ma soprattutto dalla progettazione di un sistema di interazione della proiezione con la figura umana. Già introdotto nei primi anni 2000 con i progetti di Klaus Obermaier e di Art+Com (il loro progetto di teatro lirico The jew of Malta viene citato da Lev Manovich come esempio brillante di software culture a teatro) l’interazione del performer con la scena digitale diventa una sorta di soglia obbligata: dopo i tentativi di utilizzare l’armatura della MoCap (da Roberto Latini a Marcel,li Antunez Roca) e un arsenale di sensoristica, viene sperimentata la kinect per la motion capture live. La kinect è il controller cinetico di Xbox che entra in commercio nell’ambito dei videogame nel 2010. Ha una barra motorizzata in grado di seguire tramite video, i movimenti dei giocatori, orientandosi nella posizione migliore per il riconoscimento dei movimenti La periferica era in grado di rilevare e leggere fino a sei corpi in simultaneo. Adrian Mondot (del duo AM&CB) crea con la Kinect il prototipo di uno spettacolo ad alto tasso di interazione, pur con una tecnologia semplificata ma originaria: il primo spettacolo è Cinematique (a cui seguiranno altri) ed è sviluppato a partire dal software proprietario Emotion che integra dinamica di movimento, oggetti grafici e mapping grazie proprio alla Kinect.

4. Ma non è abbastanza reale! Il face mapping

La kinect nello spettacolo riconosceva le ombre, le forme, la luce e i movimenti ma non andava a identificare specificamente il soggetto, il quale poteva anche non essere reale ma una semplice marionetta. Occorreva mappare il volto per approdare a una “realtà” vera.

Il live face mapping è un formato che si è andato a perfezionare a partire da un prototipo di Nobumichi Asai del 2014 presentato ad Ars Electronica. Si chiamava OMOTE termine giapponese per indicare la maschera (proprio la maschera giapponese Nogaku, maschera come zona liminale tra esterno e interno). Venne usato un sistema integrato di face tracking (in particolare il sistema di motion capture Optitrack) e mapping (con il software Live mapper) usando sensori/marker per il rilevamento del volto, del movimento. dei muscoli facciali. Era tecnicamente molto difficile all’epoca tracciare e quindi proiettare immagini aderenti al volto in tempo reale. Nessuno lo ha fatto prima a quel livello di perfezione perché il processo è piuttosto complesso: bisognava rilevare i dati dei sensori, elaborare i dati, calcolare la posizione e l’orientamento del viso, far combaciare il modello in Computer Graphics del viso con la sua texture animata e infine inviare l’immagine sul volto tramite proiettore.

5. Ma non è ancora abbastanza reale! Verso il

Dynamic projection mapping

Il soggetto nel primo face tracking progettato per lo più doveva stare fermo o muoversi limitatamente per il problema della latency. Nel 2017 l sistema Dynamic projection mapping sviluppato dal Watanabe laboratory dell’University of Tokyo risolve il problema e sarà proprio Nabumichi Asai a mostrarlo al mondo il giorno dell’anniversario della bomba su Hiroshima con un video mapping live sul volto delle performer che diventavano maschere di morte.

Un proiettore ad alta velocità che può proiettare immagini a 1000 frame al secondo: unito a un sistema altrettanto veloce di rilevamento dati, dà effetto di una metamorfosi del viso in tempo reale. Le immagini virtuali proiettate sono connesse strettamente con il movimento reale del corpo: la maschera digitale aderisce perfettamente e l’illusione di realtà è completa. Anche nella scenografia si risolve il problema della latenza delle immagini del mapping su superfici mobili: queste diventano tutt’uno con la superficie restituendo un’effetto pitturato (come nel caso del Ring di Lepage).

6. La svolta algoritmica: la Realtà vista dalle macchine.

Nel teatro tecnologico tutto cambia con quella che è stata definita da Simone Arcagni “la svolta algoritmica” ovvero “il passaggio all’uso di software di computer vision in grado di trasformare in informazioni visive gli input di vari sensori, e dal machine learning che mette a disposizione delle macchine un’ampia autonomia decisionale“.

Nel 2017 la Kinect esce di produzione, gli analisti del mercato dicono che è dovuto al fatto che per i videogames oggi funziona di più la Realtà Virtuale. A mio avviso il tema invece, è quello del riconoscimento reale del corpo (e del volto soprattutto, perchè contiene la maggior parte delle nostre informazioni specifiche). Oggi qualunque dispositivo mobile ha la possibilità di questo riconoscimento come FACE ID dell’IPHONE. Come si legge dalle caratteristiche tecniche, la telecamera TRUE DEPTH utilizzata per l’autenticazione del cellulare con il volto, acquisisce con precisione i dati proiettando e analizzando più di 30.000 punti invisibili per creare una mappa di profondità del viso; inoltre cattura un’immagine a infrarossi. Una parte del motore neurale del chip A11, A12 Bionic e A12X Bionic (protetto all’interno di Secure Enclave) trasforma la mappa di profondità e l’immagine a infrarossi in una rappresentazione matematica che confronta con i dati facciali registrati.

Inoltre già da alcuni anni software liberi come Open CV di Intel riuscivano a fare un rilevamento facciale (facial detection). La community di OpenCV è molto attiva: il famoso algoritmo di Viola-Jones che vede la luce già nel 2001, apre le porte a molteplici sperimentazioni di Computer vision aumentando il raggio di applicazioni della Intelligenza Artificiale. Nel 2009 nasce IMageNet enorme database di immagini ideata dalla ingegnere cinese Fei-Fei-Li e dal suo staff : un tentativo di classificare ogni elemento della realtà con un nuovo glossario, attribuendo a ogni immagine non più solo parole chiave ma una serie di “synonym set” or “synset”, una sorta di rete di parole associate all’immagine. Una nuova interpretazione del mondo a vantaggio delle macchine. La versione avanzata cioè il Large scale Visual recognition Challenge sviluppa un algoritmo che potrà far riconoscere, identificare e classificare gli oggetti con una precisione straordinaria. Si parla di una percentuale di errore del 5%. Che le macchine aggregando dati possano vedere meglio di noi è un dato di fatto: il problema è catalogarli. Dalla medicina alla sorveglianza, questi dispositivi di AI cambieranno ogni modalità di lavoro e di ricerca e avranno un impatto decisivo su tutta la nostra vita. Come ben ci illustra Lev Manovich nel suo recente libro AI ESTHETICS:

http://manovich.net/index.php/projects/ai-aesthetics

7.E A TEATRO?

Una nuova generazione di sistemi basati sul machine learning e sulle reti neurali sta rendendo possibile rilevare il linguaggio del corpo direttamente dalle immagini. Dopo venti anni di sperimentazioni con la motion capture per registrazione azioni e imprimerle a un personaggio virtuale oggi con un software come Openpose tutto è diventato semplicissimo: una telecamera rileva qualunque tipo di movimento e riconosce e classifica espressioni.

da https://medium.com/@samim/human-pose-detection-51268e95ddc2

La AI –processo in base al quale “una macchina si comporta in modi che sarebbero definiti intelligenti se fossero fatti da un uomo” – definizione del 1955 di Johm Mac Carthy- nasce originariamente per insegnare al computer una serie di cognitive task: dal risolvere problemi matematici al comprendere la scrittura e il linguaggio parlato, riconoscere le immagini. Con l’avvento di potenti processori in grado di archiviare e gestire big data, dati variabili, ed elaborarli con grande velocità, si passa da computer che fanno quello per cui sono programmati a computer che autoapprendono (da qui il tema del machine learning), cioè immagazzinano informazioni provenienti da miliardi di banche dati che sono la benzina di cui si alimentano continuamente per evolvere la loro analisi dei dati.

8.Cosa dice la vostra AI di voi?

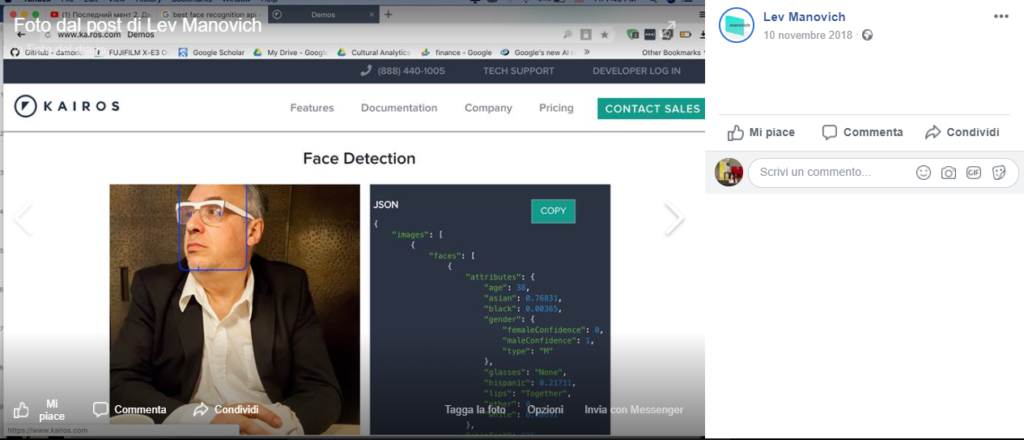

Fece scalpore un post del grande teorico dei new media Lev Manovich che provò su di sé il test del Software Kairos e Clarafai consistente in un sistema di algoritmi di Computer vision ed è risultato un uomo di 38 anni di razza asiatica o sudamericana. Qualcosa non funziona nell’analisi dei dati: eppure questa funzione predittiva (predictive policing ) delle AI. è attualmente in uso dalla Agenzia nazionale per la sicurezza negli States.

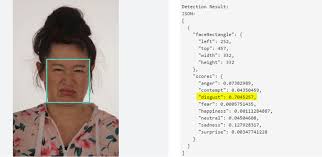

Vogliamo lasciare alle macchine l’interpretazione dei nostri stati d’animo da un frame di un sopracciglio, la classificazione sociale in base alla presunzione di riconoscere la razza dagli zigomi? E chi gestirà questi dati? Nel simposio tenuto da Hyto Steyerl al Castello di Rivoli e in particolar nel suo speech (dal titolo impegnativo e che va a ritroso alle immagini del MedioEvo Quante intelligenze artificiali possono ballare sulla punta di uno spillo?) si è parlato delle conseguenze sociali e politiche derivata dall’uso sistematico degli automatismi delle AI per identificare sospetti e introdurre un sistema di controllo sociale. Siamo di fronte a un nuovo Lombrosismo digitale? Un esempio riportato da Hito Steyerl è questa ricerca dal titolo molto chiaro Automated Inference on Criminality using Face Images https://www.semanticscholar.org/paper/Automated-Inference-on-Criminality-using-Face-Wu-Zhang/1cd357b675a659413e8abf2eafad2a463272a85f

E in direzione della Realtà va anche ADOBE che ha messo in commercio un nuovo strumento di AI per riconoscere foto “photoshoppate” con l’intento di dare una svolta “etica” all’azienda, riconoscendo la problematica dei contenuti “fake”.

L’artista che come la STEYERL sta smascherando il potenziale pericolo sulla riservatezza dei dati e sulla terrificante ipotesi di classificazione degli esseri umani viene svelato da Trevor Paglen, definito per il suo impegno attivista lo “Snowden dell’arte”. Nella serie Invisible Images è la stessa Steyerl a essere il soggetto dell’opera nelle “fotografie fatte dalle macchine per essere lette dalle macchine”.

9.Da Deafman glance a Sight machine-Una questione di sguardi

La stessa tecnologia di CV Computer Vision usata per le telecamere di sorveglianza, viene applicata a un concerto live con i Kronos quartet dal titolo significativo Sight machine che riconosce oggetti e soggetti, ha in memoria la loro attività e interpreta le espressioni dei performer da cui ne deduce orientamenti sessuali e politici. Le macchine ci osservano e vedono il nostro mondo attraverso le stesse deviazioni interpretative che imparano dalla quantità di dati prelevati dalle banche dati mondiali. Come difendersi? Diamo quindi per assodato il fatto che i computer siano in grado di imparare da noi, una volta che gli forniamo un numero sufficiente di esempi da studiare, diventa allora fondamentale concentrarsi proprio su quali informazioni stiamo passando all’Intelligenza Artificiale.

Qua Paglen nel finale dello spettacolo di musica SIGHT MACHINE mette lo spettatore in guardia di fronte a tecnologie non generiche ma che riguardano tutti noi: la stessa telecamera che riprendeva i musicisti ora riprende il pubblico che viene classificato in base ai dati in possesso della AI: uno scenario inquietante non più da 1984 ma da Black mirror. Il teatro, come ben auspicava Brecht, torna a essere luogo per una riflessione critica collettiva della società e della coscienza, di una necessaria riacquisizione della Realtà a cui rischiamo di non avere più accesso diretto.